先拋個磚。

價值觀的問題,很多時候我們將其視作AI倫理問題,毫無疑問是越來越受到業界的關註了。

雖然討論到價值觀的時候,可能並不像討論具體演算法有那麽高級的技術、奪目的效果、重新整理紀錄的成績,也不像討論人物、故事那樣有光環、有意思,但如果不提價值觀,總有一天AI領域會面臨和生物醫學領域一樣的問題(別跑,說的就是某位賀教授)。

早先,我們看到在國外,一些企業和知名人物在強調AI價值觀的問題,比如谷歌就在2018年釋出了AI七原則:

AI套用目標:我們相信AI應當

1、對社會有益。

2、避免制造或加劇偏見。

3、提前測試以保證安全。

4、由人類擔責。

5、保證私密。

6、堅持科學高標準。

7、從主要用途、技術獨特性、規模等方面來權衡。

我們不會將AI套用於:

1.制造整體傷害之處。如一項技術可能造成傷害,我們只會在其好處大大超過傷害的情況下進行,並提供安全措施;

2.武器或其他用於直接傷害人類的產品;

3.收集使用資訊,以實作違反國際規範的監控的技術;

4.目標違反被廣泛接受的國際法與人權原則的技術。

量子位:剛剛,Google釋出AI七原則:不開發武器,但會繼續與軍方合作

還有李飛飛的AI4ALL公益組織,希望讓那些不太「主流」的人群——比如女性、有色人種——也參與到AI的建設中,防止模型跑的太「白皮膚直男」。

http:// ai-4-all.org/

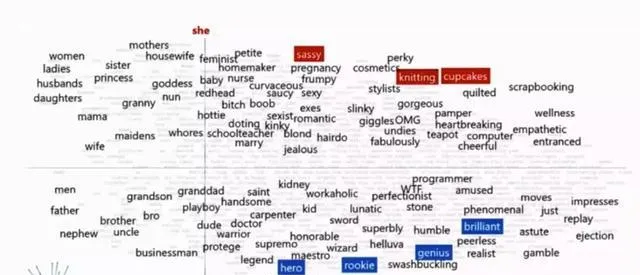

就在前幾天,沈向洋續聘清華後的首場演講,也提到了一些價值觀的問題,舉了詞嵌入系統中的問題:

詞嵌入系統中,當主語分別是「她(she)」和「他(he)」時,出現的詞是不一樣的:她是「姐妹」,他是「兄弟」;

她是「護士」,他是「大夫」;

她是「家庭主婦」,他是「程式設計師」;

她說「OMG」,他說「WTF」;

她是「女權主義者」,他是「現實主義者」;

她「懷孕」了,他「腎結石」了;

……

人類,讓資料庫出了一些問題。

量子位:沈向洋創造清華歷史,成為史上首位視訊聘任的清華教授,呼籲進行可解釋的AI研究

其實總的看來,AI的價值觀偏差往往出在兩個地方:

1.數據出了偏差;

數據的偏差往往體現在一些現有的數據,本身就是不合理的。比如從社群網站中扒下來的語料庫,一定有思維定式、歧視等出現的可能。靠這樣的數據訓練處的模型,自然也會被人類影響,產生這些思維定式的偏差。

不過,數據的創造者本身也是人。人類,本身就內建偏見這個debuff。

2.人出了偏差。

這也是李飛飛的AI4ALL所擔心的問題,AI系統很多時候是需要做決策的,如果對AI有巨大影響的系統,只是用了一兩個人,或者一兩類人的價值觀,那做出的決策必定對其他人是不公平的,創造技術暴政。

而在套用方面,考慮到價值觀倫理問題,比較適合套用的領域有:

1、人類能力不足的領域。比如醫療,疫情中大家也看到了,醫療資源不足,沒有足夠的醫生護士;還有救援,很多時候人是無法第一時間趕到災難現場進行營救的。

2、不安全環境的工作。比如有放射線/粉塵的作業環境、面對犯罪分子/恐怖分子的時候、還有長期工作會給人造成身體器官過勞損害的工廠流水線工作。

3、需要監控值守的工作。比如24小時待命的各類監控系統,這些並不是所有都能在AI套用之前實作自動化的。

而目前看來,普遍受到地址的AI套用領域,就是軍事了,軍事訂單也一度引發了谷歌的員工大遊行。但這也要攻防分開來看,軍事中的戰備、後援、醫療、偵查,套用AI的阻力並沒有那麽大,但如果有人要制造AI武器,恐怕會引起巨大的反對聲浪。