先抛个砖。

价值观的问题,很多时候我们将其视作AI伦理问题,毫无疑问是越来越受到业界的关注了。

虽然讨论到价值观的时候,可能并不像讨论具体算法有那么高级的技术、夺目的效果、刷新纪录的成绩,也不像讨论人物、故事那样有光环、有意思,但如果不提价值观,总有一天AI领域会面临和生物医学领域一样的问题(别跑,说的就是某位贺教授)。

早先,我们看到在国外,一些企业和知名人物在强调AI价值观的问题,比如谷歌就在2018年发布了AI七原则:

AI应用目标:我们相信AI应当

1、对社会有益。

2、避免制造或加剧偏见。

3、提前测试以保证安全。

4、由人类担责。

5、保证隐私。

6、坚持科学高标准。

7、从主要用途、技术独特性、规模等方面来权衡。

我们不会将AI应用于:

1.制造整体伤害之处。如一项技术可能造成伤害,我们只会在其好处大大超过伤害的情况下进行,并提供安全措施;

2.武器或其他用于直接伤害人类的产品;

3.收集使用信息,以实现违反国际规范的监控的技术;

4.目标违反被广泛接受的国际法与人权原则的技术。

量子位:刚刚,Google发布AI七原则:不开发武器,但会继续与军方合作

还有李飞飞的AI4ALL公益组织,希望让那些不太「主流」的人群——比如女性、有色人种——也参与到AI的建设中,防止模型跑的太「白皮肤直男」。

http:// ai-4-all.org/

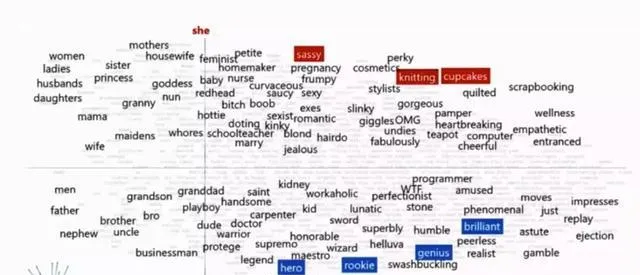

就在前几天,沈向洋续聘清华后的首场演讲,也提到了一些价值观的问题,举了词嵌入系统中的问题:

词嵌入系统中,当主语分别是「她(she)」和「他(he)」时,出现的词是不一样的:她是「姐妹」,他是「兄弟」;

她是「护士」,他是「大夫」;

她是「家庭主妇」,他是「程序员」;

她说「OMG」,他说「WTF」;

她是「女权主义者」,他是「现实主义者」;

她「怀孕」了,他「肾结石」了;

……

人类,让数据库出了一些问题。

量子位:沈向洋创造清华历史,成为史上首位视频聘任的清华教授,呼吁进行可解释的AI研究

其实总的看来,AI的价值观偏差往往出在两个地方:

1.数据出了偏差;

数据的偏差往往体现在一些现有的数据,本身就是不合理的。比如从社交网站中扒下来的语料库,一定有思维定式、歧视等出现的可能。靠这样的数据训练处的模型,自然也会被人类影响,产生这些思维定式的偏差。

不过,数据的创造者本身也是人。人类,本身就自带偏见这个debuff。

2.人出了偏差。

这也是李飞飞的AI4ALL所担心的问题,AI系统很多时候是需要做决策的,如果对AI有巨大影响的系统,只是用了一两个人,或者一两类人的价值观,那做出的决策必定对其他人是不公平的,创造技术暴政。

而在应用方面,考虑到价值观伦理问题,比较适合应用的领域有:

1、人类能力不足的领域。比如医疗,疫情中大家也看到了,医疗资源不足,没有足够的医生护士;还有救援,很多时候人是无法第一时间赶到灾难现场进行营救的。

2、不安全环境的工作。比如有辐射/粉尘的作业环境、面对犯罪分子/恐怖分子的时候、还有长期工作会给人造成身体器官过劳损害的工厂流水线工作。

3、需要监控值守的工作。比如24小时待命的各类监控系统,这些并不是所有都能在AI应用之前实现自动化的。

而目前看来,普遍受到地址的AI应用领域,就是军事了,军事订单也一度引发了谷歌的员工大游行。但这也要攻防分开来看,军事中的战备、后援、医疗、侦查,应用AI的阻力并没有那么大,但如果有人要制造AI武器,恐怕会引起巨大的反对声浪。