没有具体方向的话建议先看一些机器人视觉公司的方案,比如pickit! 梅卡曼得,我就不一一举例了,百度一个进入看整体方案描述就可以的。

假设你是要做三维bin picking类的分拣系统:

1图像处理,非常重要,这个不用说了吧,起码对着经典的课程撸一遍,或者跟着宾夕法尼亚的机器人感知学,再或者去睿慕课找一门课程上1.5或者2倍速听一听。

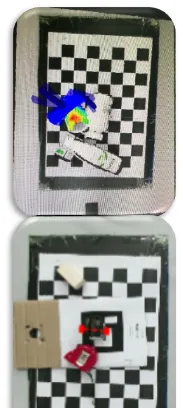

2手眼标定是会用到的,虽然不用定位为研究方向,解个ax=xb还是机器人视觉解决中比较重要的一环。

3机器人路径规划,这个可做可不做,用一些机器人自带的外部接口,比如urscript上movel movej servoj,再比如ABB的EGM,KUKA的…… 在你去百度机器人视觉公司的时候会发现他们支持的机器人类型都是差不多的,因为都是调用的外部接口。如果想考虑避障和效率问题等,比如要规划抓取箱体内的物体或者机械臂需要尽量避开正上当的相机的视野,就需要做路径规划的工作,这部分知乎上大牛的文章和推荐都比较多。

4很有可能上面的内容都不想了解,只想做深度图处理现在,深度图顾名思义就是带有深度信息的图,这是一句废话,但是不说好像还不行。我们平时帅气的自拍是有颜色的,每个里面包含了RGB信息,那黑乎乎的深度图里就是DEPTH啦,当然也可以RGBD。以下称Depth为z值吧,有了z值通过相机内参就可以得到xy值,也就是深度信息了。如果说不明白内参的话,建议去学第一条!

6物料该怎么抓取,这是一个要么深要么浅的问题,可以做学术研究,也可以直接离线或在线示教,看自身需求,大多数在展会上看到的方案都是后者。

7怎么匹配到你要抓取的物体,也就是抓取系统中最最重要的一环,如何匹配定位到待抓取物体,这个是可以作为研究方向的主攻的,可以先去了解opencv pcl二维或者三维的模版匹配,再去做基于深度学习的物体检测。这个地方展开说的话内容就太多了,手机码字不易也没有什么图,干巴巴的,等我有时间用电脑再补充,假如有人看的话……

基于深度学习的物体抓取目前我接触到的主要有两条路,基于彩色图分割+传统icp类:这种方法的好处是对于分割,我们本身的诉求就是找到待抓取物体的类型及在图像中的位置,大大提高匹配定位的效率,而分割后映射到深度图上的三维信息经过传统方法定位得到的pose更准,甚至如果分割模型做的准一点,对于小食品及快递包裹类,后面只需要定义一个吸取规则就可以了;另外就是直接上三维深度学习出6d pose了,这部分我接触过很多种了,从dexnet GPD 到 poseCNN ssd6d等,还有一些其他小天才们尝试过的方法我就先不提了,好处是更适合做研究发paper,但是做出来的东西没有前面的路线高效高成功率。

上几个图:

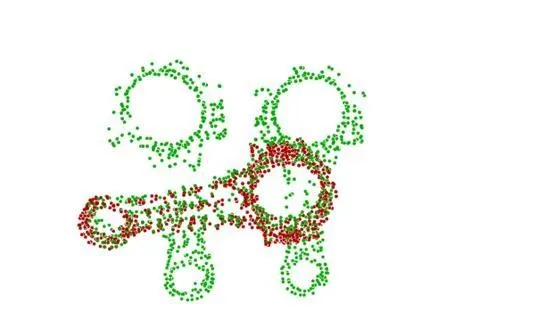

匹配的效果大概是这个样子:

其他:

硬件的话,买一个深度相机realsense这种才一千多,学习还是够用的。

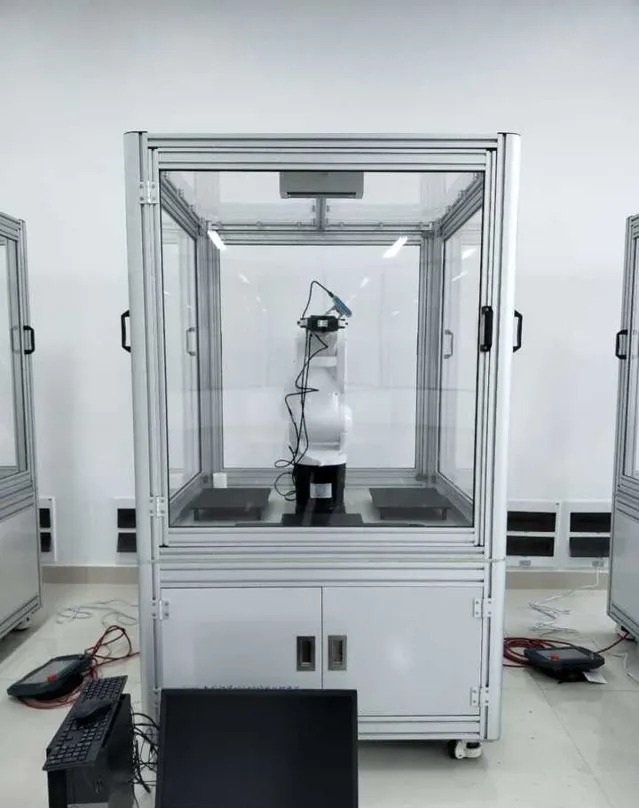

上一个我的实验环境:

先说这么多……手机码字很痛苦,主要我要点外卖了。