量子位 | 公眾號 QbitAI

家人們,大模型圈兒出了個驚天大瓜——

史丹佛 AI團隊,竟然曝出了 抄襲 事件,而且抄襲的還是中國國產的大模型成果——模型結構和程式碼,幾乎一模一樣!跟任何抄襲事故一樣……AI圈內都驚呆了。

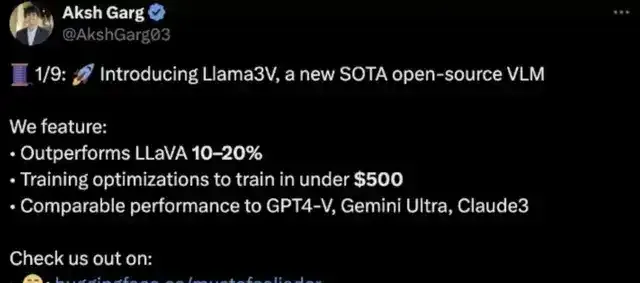

史丹佛的這項研究叫做 Llama3-V ,是於5月29日新鮮釋出,宣稱只需要500美元就能訓出一個SOTA多模態大模型,比GPT-4V、Gemini Ultra、Claude Opus都強。

Llama3-V的3位作者或許是擁有名校頭銜加持,又有特斯拉、SpaceX的大廠相關背景,這個專案短短幾天就受到了不小的關註。

甚至一度沖上了HuggingFace趨勢榜首頁:

然而,戲劇性的一幕開始上演了。

有位細心的網友發現,咦?這「配方」怎麽如此的熟悉?

然後他定睛一看,好家夥,這不就是 MiniCPM-Llama3-V 2.5 (出自清華系明星創業公司 面壁智能 )嘛。

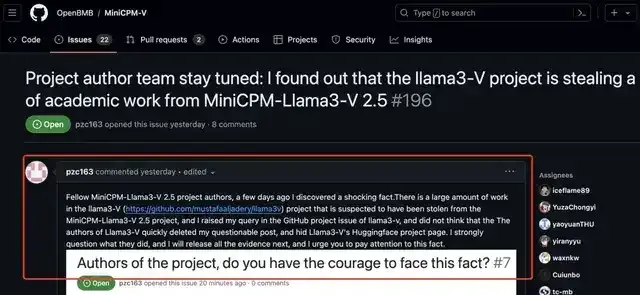

於是這位網友便跑到面壁智能GitHub專案下開始爆料了:

你們家大模型被史丹佛團隊抄襲了

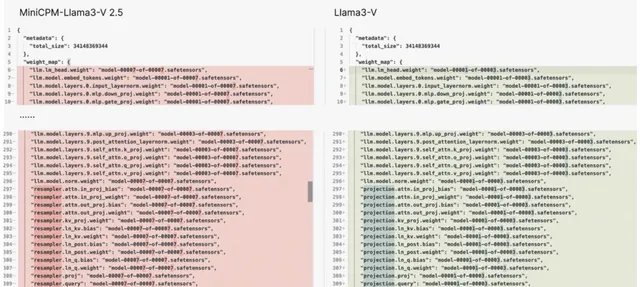

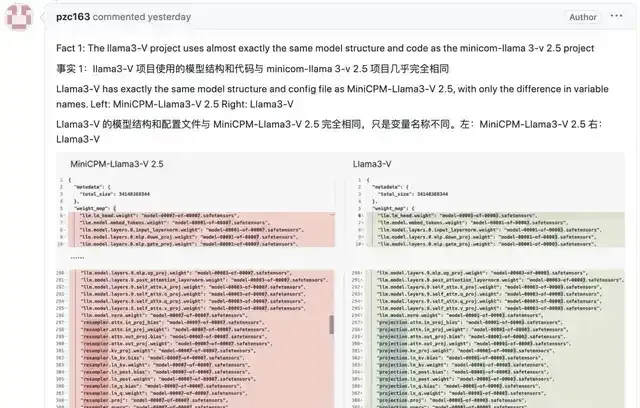

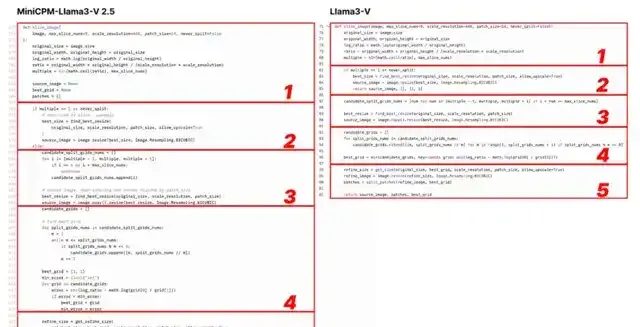

並且他還附上了一堆的證據,最直接的莫過於這張2個模型程式碼的對比圖了:

Emmm……用這位網友的話來說就是:

模型結構、程式碼、配置檔,簡直一模一樣,只是變量名變了而已。

至於為什麽這位網友要跑到面壁智能GitHub專案下面留言,是因為他之前已經給Llama3-V作者留過言了,但史丹佛團隊的做法竟是 刪庫跑路 ……

沒錯,現在不論是GitHub還是HuggingFace, 統統都是404 :

並且這事現在還在持續發酵的過程中,網上吃瓜的群眾也是越來越多。

那麽我先來一同回顧一下這件drama事情的始末。

「程式碼和架構一模一樣」

正如剛才所述,一個網友爆料Llama3-V抄襲MiniCPM-Llama3-V 2.5,跑到面壁智能的GitHub主頁提醒團隊註意,並把關鍵證據都一一截圖列舉整理了下來,這才有了整個抄襲門的還原現場。

以下是來自這位網友的證據。

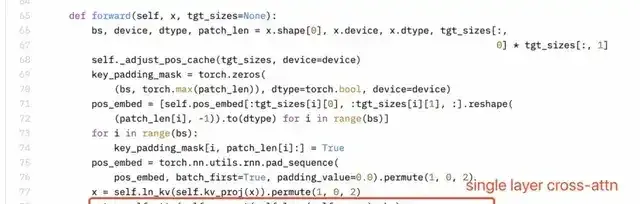

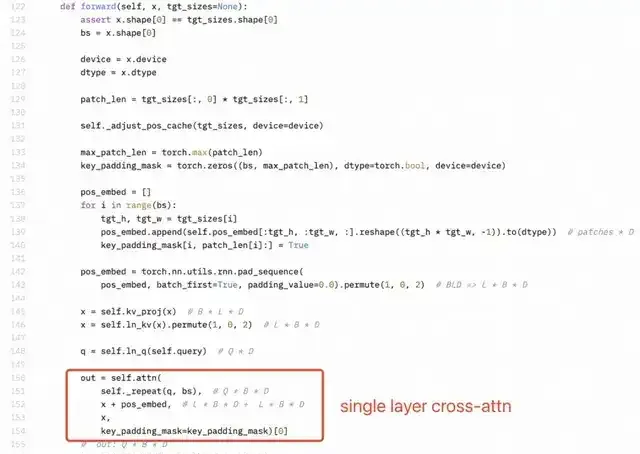

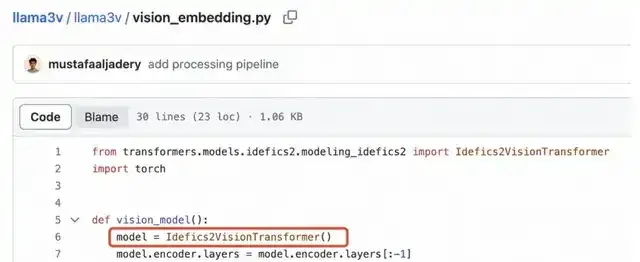

證據一,Llama3-V的模型架構和程式碼與MiniCPM-Llama3-V 2.5幾乎完全相同:

看下面的例子,配置檔就改了影像切片、分詞器、重采樣器和數據載入等格式化和變量名:

Llama3-V作者表示參考了LLaVA-UHD架構,在ViT和LLM等選擇上有一些差異。但實際上,網友發現他們的具體實作在空間模式等很多方面都與LLaVA-UHD不同,卻出奇與MiniCPM-Llama3-V 2.5一致。

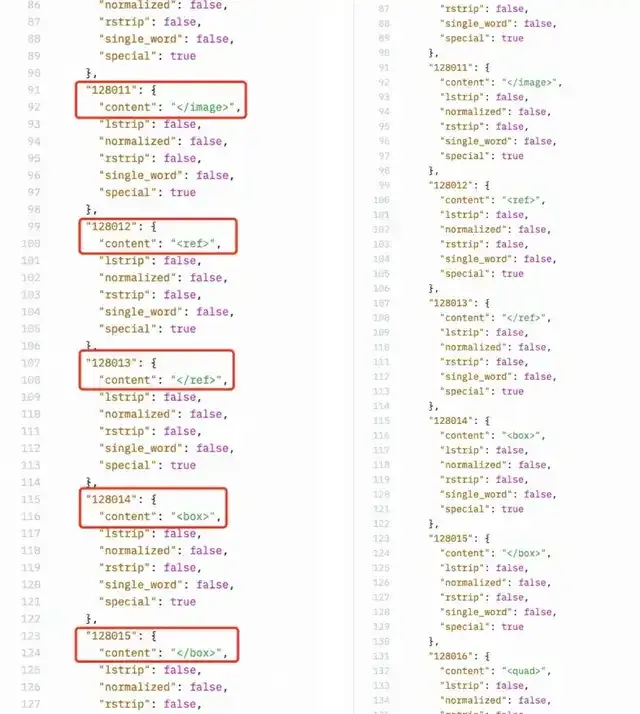

甚至,Llama3-V還用了MiniCPM-Llama3-V 2.5的分詞器,連 MiniCPM-Llama3-V 2.5定義的特殊符號都 能「巧合」實屬離譜。

證據二,網友質疑Llama3-V作者是如何在MinicPM-Llama3-V2.5專案釋出之前就使用上MinicPM-Llama3-V2.5分詞器的。

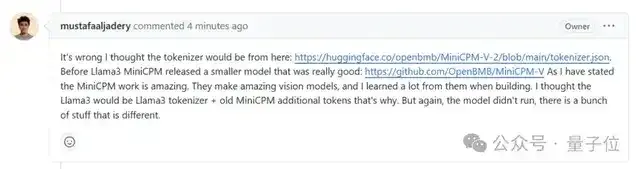

Llama3-V作者給的回復是這樣嬸兒的,說是用的面壁智能上一代MinicPM-V-2專案的:

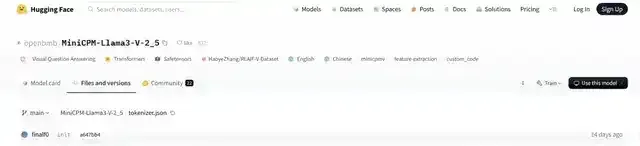

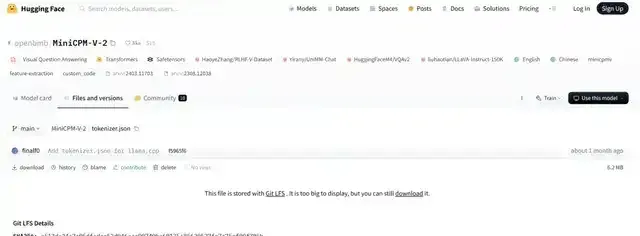

但事實卻是,HuggingFace中,MiniCPM-V2與MiniCPM-Llama3-V 2.5分詞器分別是兩個檔,檔大小也完全不同。

MiniCPM-Llama3-V 2.5的分詞器是用Llama3分詞器加上MiniCPM-V系列模型的特殊token組成,而MiniCPM-V2的釋出都在Llama3開源之前,怎麽會有Llama3分詞器。

證據三,Llama3-V作者隨後無故刪除了網友在Llama3-V頁面上送出的質疑他們抄襲的問題。

而且,他們似乎對MiniCPM-Llama3-V 2.5架構或他們自己的程式碼都不完全了解。

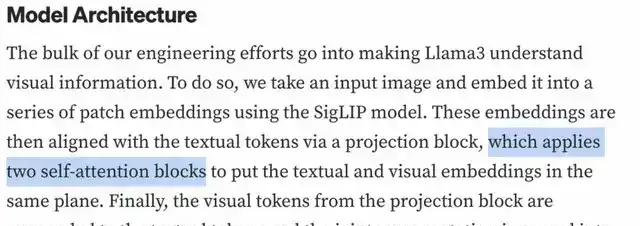

感知器重采樣器(Perceiver resampler)是單層交叉註意力,而不是雙層自註意力。但是下圖所示Llama3-V的技術網誌裏作者的理解很明顯是錯的。

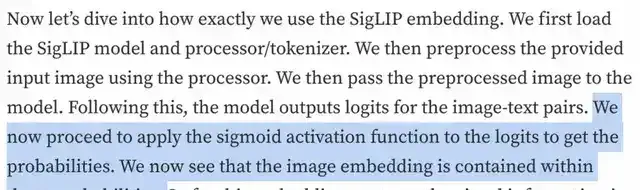

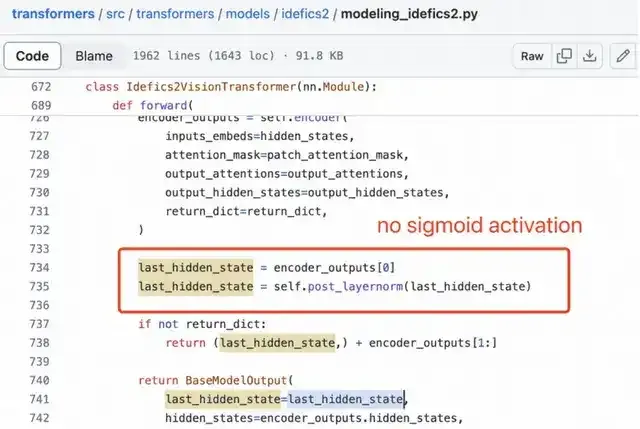

SigLIP的Sigmoid啟用也不用於訓練多模態大語言模型,而僅用於預訓練SigLIP。

視覺特征提取不需要Sigmoid啟用:

基於以上三點事實,這位網友認為足以證據證明Llama3-V專案竊取了MiniCPM-Llama3-V 2.5專案的學術成果。

但還沒完,他隨後又補充了兩點證據。

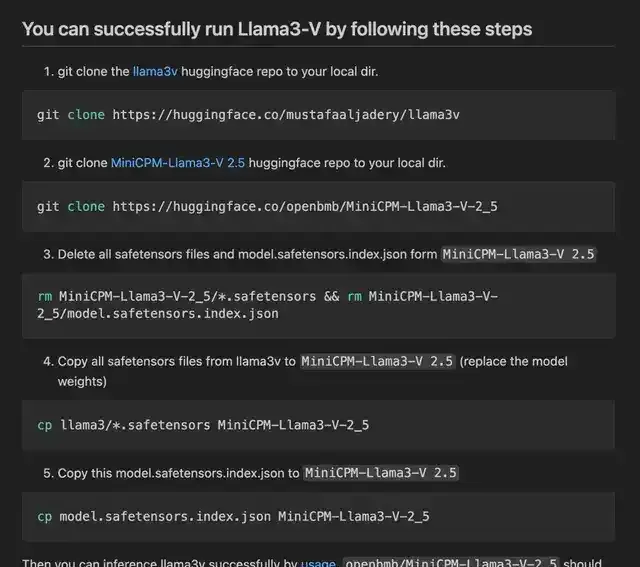

幾天前,當這位網友嘗試執行Llama3-V時,發現他們提供的程式碼無法與HuggingFace的checkpoint一起使用,反饋問題沒有得到作者回復。

於是網友把從HuggingFace下載的Llama3-V模型權重中的變量名改成了MiniCPM-Llama3-V 2.5的,驚奇發現模型居然可以用MiniCPM-V程式碼成功執行

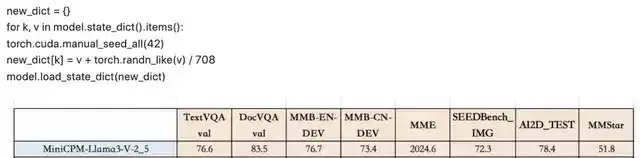

此外,如果將高斯雜訊(由單個純量參數化)添加到MiniCPM-Llama3-V 2.5的checkpoint,結果就是會得到一個行為與Llama3-V極其相似的模型。

收到網友的提醒後,MiniCPM-Llama3-V 2.5團隊這邊也迅速展開了調查,他們按照網友的在GitHub上的說明,使用 Llama3-V的checkpoint和MiniCPM-Llama3-V 2.5的程式碼和配置檔正確獲取了推理結果。

於是,一個更為關鍵性的證據出現了。

Llama3-V在一些未公開的實驗性特征上表現出與MiniCPM-Llama3-V 2.5高度相似的行為,而這些特征是根據MiniCPM-Llama3-V 2.5團隊內部數據訓練的。

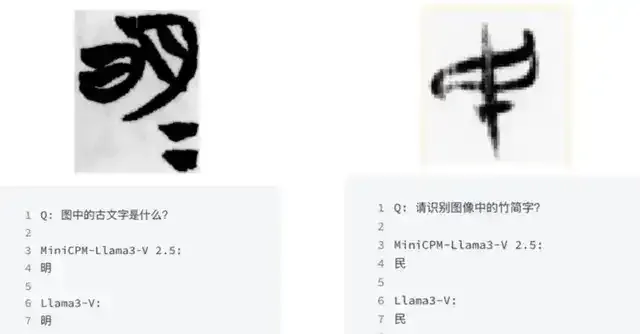

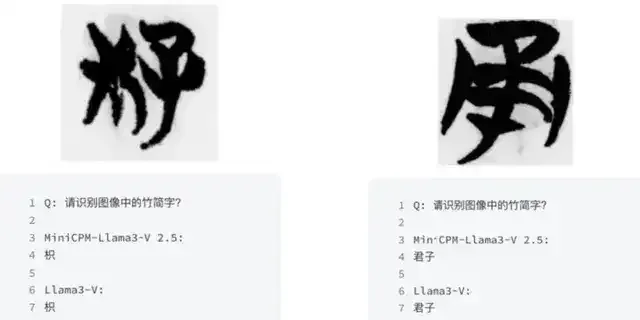

例如, 辨識清華簡 !

MiniCPM-Llama3-V 2.5特有的功能之一是辨識清華簡,這是一種非常罕見、於戰國時期寫在竹子上的中國古代文字。

訓練影像是從最近出土的文物中掃描出來的,由MiniCPM-Llama3-V 2.5團隊進行了標註,尚未公開釋出。

而Llama3-V的辨識情況和MiniCPM-Llama3-V 2.5極為相似。

辨識錯誤的情況竟也出奇一致:

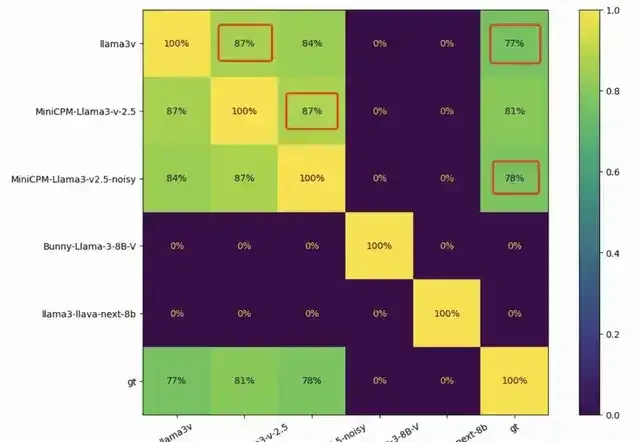

MiniCPM-Llama3-V 2.5團隊還在1000 張竹簡影像上測試了幾種基於Llama3的視覺-語言模型,並比較了每對模型的預測精確匹配。

結果,每兩個模型之間的重疊為零,而Llama3-V和MiniCPM-Llama3-V 2.5之間的&&重疊達到了驚人的87%**。

此外,MiniCPM-Llama3-V 2.5和Llama3-V 甚至具有相似的錯誤分布 。Llama3-V和MiniCPM-Llama3-V 2.5分別做出 236和194個錯誤預測,重疊部份為182個。

且按照網友在GitHub上的指令獲得的MiniCPM-Llama3-V2.5-noisy顯示出與Llama3-V幾乎相同的定量結果,真令人匪夷所思……

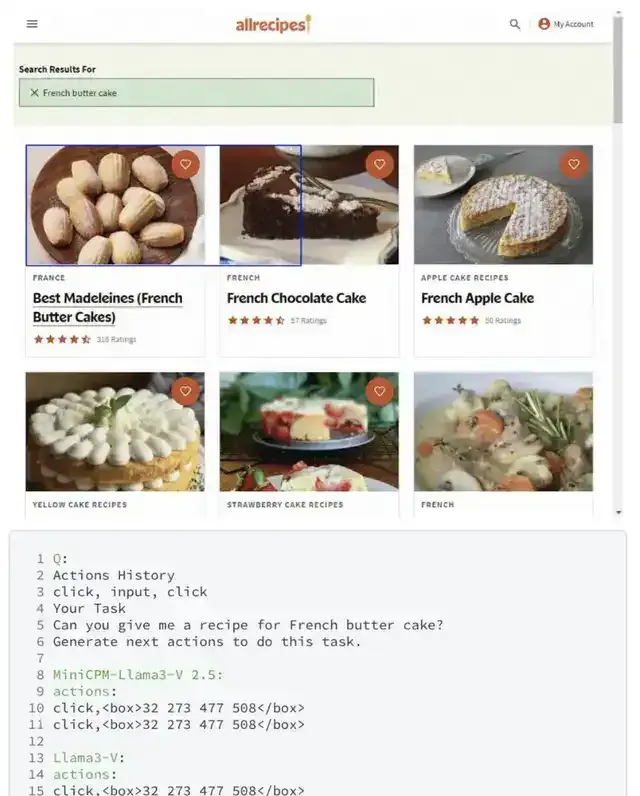

在另一個MiniCPM-Llama3-V 2.5內部數據上訓練的未公開功能——WebAgent上,也出現了同樣的情況。

Llama3-V甚至和MiniCPM-Llama3-V 2.5團隊新定義的WebAgent模式中犯的錯誤都一樣。

鑒於這些結果,MiniCPM-Llama3-V 2.5團隊表示很難將這種不尋常的相似性解釋為巧合,希望Llama3-V作者能對這個問題給出一個正式的解釋。

史丹佛團隊已刪庫跑路

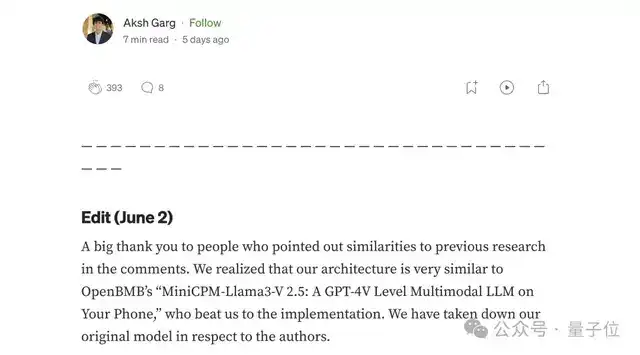

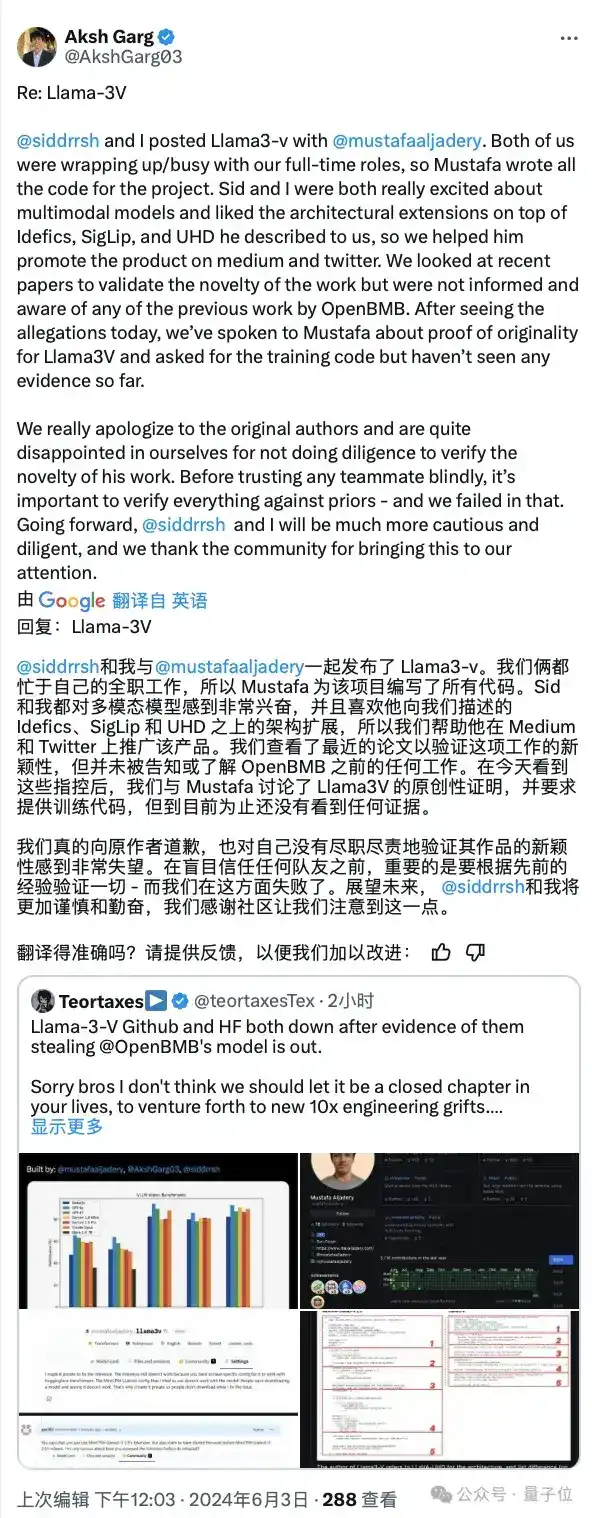

雖然史丹佛的2位本科生已經下架了幾乎所有與之相關的專案,但其實在此之前,他們最初在面對質疑的時候還是做出了些許的解釋。

例如他們強調,Llama3-V這項工作的時間是要早於面壁智能的MiniCPM,只是使用了他們的tokenizer。

不過作者對Medium上的聲明還是做了保留:

非常感謝那些在評論中指出與之前研究相似之處的人。

我們意識到我們的架構非常類似於OpenBMB的「MiniCPM-Llama3-V 2.5,他們在實作上比我們搶先一步。

我們已經刪除了關於作者的原始模型。

對此,一部份網友表示,既然選擇刪掉專案,那麽就表示確實存在一定的問題。

不過另一方面,對於抄襲這事也有不一樣的聲音——

MiniCPM-Llama3-V 2.5不也是在Llama3的基礎上做的改良嗎?不過連tokenizer都直接拿來用就應該不算是借鑒了。

而就在剛剛,另一個戲劇性的事情發生了。

史丹佛的作者在中午時間做出了最新的回應:

但現在……這條回應又刪掉了

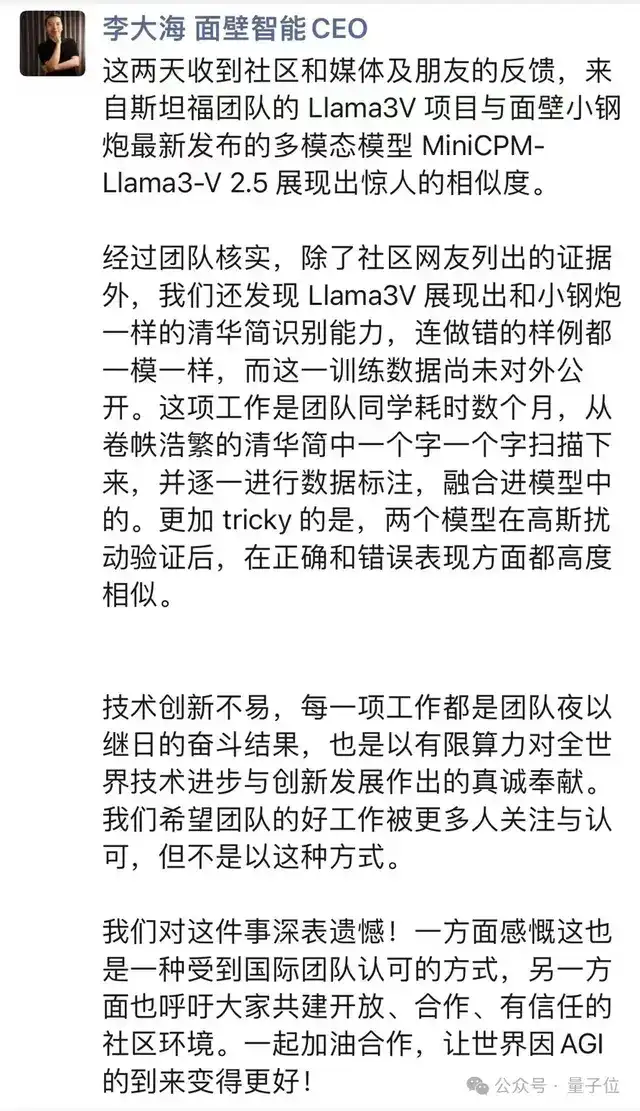

而面壁智能這邊,CEO李大海也做出了正式回應:

參考連結:

[1]https://

github.com/OpenBMB/Mini

CPM-V/issues/196

[2]https://

github.com/mustafaaljad

ery/Llama3-V

[3]https://www.

reddit.com/r/LocalLLaMA

/comments/1d6f1f3/Llama3-V_project_is_stealing_a_lot_of_academic/

[4]https://www.

reddit.com/r/LocalLLaMA

/comments/1d6f1f3/Llama3-V_project_is_stealing_a_lot_of_academic/?rdt=41696&onetap_auto=true&one_tap=true

[5]https://

aksh-garg.medium.com/ll

ama-3v-building-an-open-source-gpt-4v-competitor-in-under-500-7dd8f1f6c9ee

—完—

@量子位 · 追蹤AI技術和產品新動態

深有感觸的朋友,歡迎贊同、關註、分享三連վ'ᴗ' ի ❤