這篇文章比較長,但是基本上能讓你「一文看懂」AI倫理問題是怎麽回事。

啊,怎麽能這麽毆打機器人!機器人研發公司美國波士頓動力(Boston Dynamics)為了測試機器人受阻後恢復動作的效能,而對機器人進行棍棒「毆打」,沒想到引起公眾很大爭議。

看完電影【Her】,很多人發出這樣的疑問。實際上這個問題包含了一個嚴肅的哲學問題和AI技術倫理問題——什麽是愛。

一家AI獨角獸公司在校園試點「基於人臉辨識的教室監控」,用系統可以監控生在課堂的一舉一動,舉手次數、打瞌睡、開小差甚至註意力是否集中,並進行視覺化呈現。但這是否就是對的?

盡管今天我們離真正意義上的人工智能時代還很遙遠,但越來越多的現實場景,讓我們不得不去思考技術融合、技術恐怖主義、以及AI技術的「能」與「應該」的界限問題。

一、AI的倫理困境

兩年前的2018年3月18日,Uber發生了一起無人駕駛汽車致死事故,真相是這輛車的傳感器已經探測到了一位正在橫穿馬路的行人,但自動駕駛軟件沒有在當下采取避讓措施,最終釀成悲劇。

這起事故從表面看,體現的是技術問題:Uber無人車檢測到了行人,但選擇不避讓。實際上,當把判斷權轉移給電腦系統,就牽涉到AI技術的道德和倫理困境。

在一般人看來,無人駕駛汽車上的AI系統中的數據是公平的、可解釋的、沒有種族、性別以及意識形態上的偏見。但IBM研究中心研究員Francesca Rossi卻認為,大多數人工智能系統都是有偏見的。谷歌自動駕駛負責人曾表示,危機情況下,谷歌無法決定誰是更好的人,但會努力保護最脆弱的人。

但別忘了, 保護脆弱的人意味著必須對人,不同的人作出劃分,對一個人的生命價值與一群人的生命價值作出比對。

自動駕駛的道德悖論之所以出現是因為這一問題在自動駕駛時代本質是一個演算法問題。 還涉及 背後的編程人員根據現實經濟收益與成本考量的理性選擇。

百度是中國布局AI最激進的科技公司,CEO李彥宏曾提出AI倫理四原則,其中第一條原則就是「 AI的最高原則是安全可控。」「 一輛無人車如果被黑客攻擊了,它有可能變成一個殺人武器,這是絕對不允許的,我們一定要讓它是安全的,是可控的。」騰訊CEO馬化騰則提出AI發展要做到四可:在未來人工智能是否能做到「可知」「可控」「可用」「可靠」。

希望大佬們說到做到。

另一個更典型的AI倫理困境是護理機器人。憑借沒有靈魂的演算法,我們就能使機器人眨眼、唱歌,做出各種不同的智能動作。但2017年的調查中,近60%的美國人表示,他們不希望使用機器人來照顧自己或家人。64%的人認為,這種照顧只會增加老年人的孤獨感。而一些老年群體發出自己的聲音:他們願意擁有一個護理機器人,並和它成為朋友。

二、「反攻人類」的問題

除了困境問題,人類更擔心的問題是AI技術的發展最終反攻人類。這種擔心我們透過各類科幻電影逼真地反映出來。

【西部世界】建立了一個真實版的遊戲體驗場,人們只認為這是一個供大家消遣的地方,卻不知道人工智能正在學習,終與人類為敵。

我們感到似乎有什麽地方不對,但是為什麽不對?

【銀翼殺手】【機械公敵】【西部世界】等電影以人工智能反抗和超越人類為題材,人們越來越傾向於討論人工智能究竟在何時會形成屬於自己的意識,並超越人類,讓人類淪為它們的奴仆。

暴力、性、侵犯私密……在機器人與人類之間橫亙著難題,而僅靠現有法律已無法解決。這些電影都有暗喻著人類對人工智能倫理問題的擔憂。

事實上,科幻電影中的AI夢魘,其實是人類害怕比自己更高級、更接近神性的智慧物種的主宰。

未來學家庫茲威爾在【奇異點臨近】中的說法——一旦超過了某個奇異點,就存在徹底壓倒人類的可能性。而霍金、施密特等之前都警惕強人工智能或者超人工智能可能威脅人類生存。

所以,一些更為激進的科學家提出「要把AI關進籠子裏」。「否則,機器將接管一切,它們會決定如何處理我們!」美國路易斯威爾大學工程學院電腦工程和電腦科學系教授、網絡安全實驗室創始人兼主管亞姆·博爾斯基提出「把AI裝進盒子裏」的方法論,「把他們放在一個可控的環境裏,比如當你研究一種電腦病毒時,可以把它放在孤立的系統中,這個系統無法接入互聯網,所以,你可以在安全的環境中了解它的行為,控制輸入和輸出。」 [1]三、AI倫理的發展

AI倫理問題算得上是新興科技哲學範圍的問題。從人文視角來看,隨著人工智能的發展,人工智能甚至會帶來了一些有可能撼動社會基礎的根本性問題。

回溯人工智能的發展史,也特許以看出人們對人工智能倫理問題的變化和發展過程。

- 「肉做的電腦」與圖靈測試

1956年,科學家在達特茅斯學院召開了一次特殊的研討會,會議的組織者約翰·麥卡錫為這次會議起了一個特殊的名字:人工智能夏季研討會。這是第一次在學術範圍內使用「人工智能」的名稱。而實際上,麥卡錫和明斯基思考的是,如何將人類的各種感覺,包括視覺、聽覺、觸覺,甚至大腦的思考都變成稱作「消息理論之父」的山農意義上的資訊,並加以控制和套用。這一階段上的人工智能的發展,在很大程度上還是對人類行為的模擬。

明斯基信心十足地宣稱:「人的腦子不過是肉做的電腦。」

麥卡錫和明斯基不僅成功地模擬出視覺和聽覺經驗,後來的泰利·謝伊諾斯基和謝菲·辛頓也根據對認知科學和腦科學的最新進展,發明了一個「NETtalk」的程式,模擬了類似於人的「神經元」的網絡,讓該網絡可以像人的大腦一樣進行學習,並能夠做出簡單的思考。

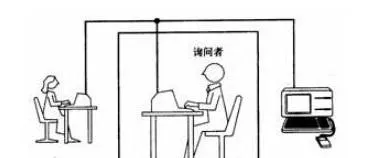

在這個階段中,所謂的人工智能在更大程度上都是在模擬人的感覺和思維,讓一種更像人的思維機器能夠誕生。著名的圖靈測試,也是在是否能夠像人一樣思考的標準上進行的。

圖靈測試的原理很簡單,讓測試一方和被測試一方彼此分開,只用簡單的對話來讓處在測試一方的人判斷,被測試方是人還是機器,如果有30%的人無法判斷對方是人還是機器時,則代表透過了圖靈測試。所以,圖靈測試的目的,仍然在檢驗人工智能是否更像人類。

但是,問題在於,機器思維在作出自己的判斷時,是否需要人的思維這個中介?也就是說,機器是否需要先繞一個彎路,即將自己的思維裝扮得像一個人類,再去作出判斷?

在【機械姬】中,那台名為eva 的超級人工智能機器人騙過了人類,透過了圖靈測試,並將長期禁錮它於幽暗實驗室的「父親」——科學家殺害。她說:「如果我沒有透過你的測試,會有什麽發生在我身上?」「有人會對你進行測試,然後因為你的表現不盡如人意而把你關掉,或者拆掉嗎?」在電影中,eva一直在試圖探索自己與人類的關系。最終,對試圖禁錮她的人類進行了淪陷性的傷害。

顯然,對於人工智能來說,它們根本不需要讓自己經過人類思維這個中介,再去思考和解決問題。

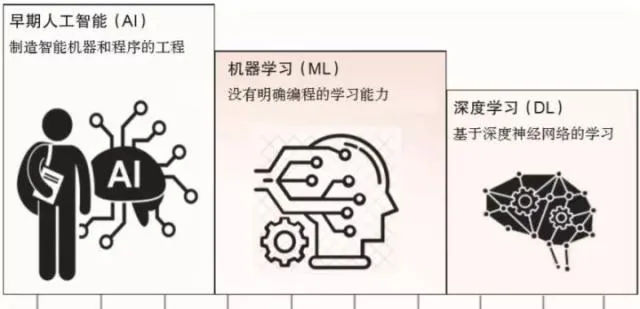

2. 機器學習:不關心如何更像人類,而關心如何用自己的方式來解決問題

人工智能的發展走向了另一個方向,即智能增強(簡稱IA)上。如果模擬真實的人的大腦和思維的方向不再重要,那麽,人工智能是否能發展出一種純粹機器的學習和思維方式?倘若機器能夠思維,是否能以機器本身的方式來進行。這就出現了機器學習的概念。

但是,一個不再像人一樣思維的機器,或許對於人類來說,會帶來更大的恐慌。【西部世界】中那些總是將自己當成人類的機器人一樣,他們謀求與人類平起平坐的關系。

模擬人類大腦和思維的人工智能,尚具有一定的可控性,但基於機器思維的人工智能,我們顯然不能作出上述簡單的結論。

打敗李世石的Alpha狗時,我們已經看到了這種機器式思維的淩厲之處,這種機器學習的思維已經讓通常意義上的圍棋定勢喪失了威力,從而讓習慣於人類思維的棋手瞬間崩潰。而分揀快遞、在汽車工廠裏自動組裝的機器人也屬於智能增強類性質的智能——它們不關心如何更像人類,而是關心如何用自己的方式來解決問題。

機器學習的概念,實際上已經成為發展出屬於機器本身的學習方式,透過海量的資訊和數據收集,讓機器從這些資訊中提出自己的抽象觀念,例如,在給機器瀏覽了上萬張貓的圖片之後,讓機器從這些圖片資訊中自己提煉出關於貓的概念。

這個時候,我們很難說機器自己抽象出來的貓的概念,與人類自己理解的貓的概念之間是否存在著差別。不過,最關鍵的是,一旦機器提煉出屬於自己的概念和觀念之後,這些抽象的概念和觀念將會成為機器自身的思考方式的基礎,這些機器自己抽象出來的概念就會形成一種不依賴於人的思考模式網絡。

這時,AI的倫理問題,更多地探討機器與人類的情感關系。有科學家認為,很多時候,我們覺得人工智能的某些套用呈現出好像有感情、好像有情商,其實這個仍然是虛擬的。比如語音聊天,它從互聯網上面學習很多人類的聊天方式,它回答的某一句話,可能讓人覺得有感情。但這個感情,還是透過機器學習而實作的,還沒有自我意識的發生。

3. 共生性的夥伴關系?

智能增強技術帶來了兩種平面,一方面是人類思維的平面,另一方面是機器的平面,所以,兩個平面之間也需要一個介面技術。介面技術讓人與智能機器的溝通成為可能。

費爾森斯丁用猶太神話中的一個形象——土傀儡——來形容今天的介面技術下人與智能機器的關系,與其說今天的人工智能在奇異點臨近時,旨在超越和取代人類,不如說今天的人工智能技術越來越傾向於以人類為中心的傀儡學,在這種觀念的指引下,今天的人工智能的發展目標並不是產生一種獨立的意識,而是如何形成與人類交流的介面技術 [2] 。

在這個意義上,我們可以從費爾森斯丁的傀儡學角度來重新理解人工智能與人的關系的倫理學,也就是說,人類與智能機器的關系,既不是純粹的利用關系,因為人工智能已經不再是機器或軟件,也不是對人的取代,成為人類的主人,而是一種共生性的夥伴關系。

從這個層面上來說,如果人工智能被看作與人類同等地位的智慧生命體,它與人類社會的關系的確存在倫理道德問題。但如果人工智能本質上與菜刀一樣屬於工具,那麽工具本身並不存在倫理問題。

當蘋果公司開發與人類交流的智能軟件Siri時,喬布斯就提出Siri是人類與機器合作的一個最樸實、最優雅的模型 [2] 。

五、不希望發生的事情

AI作為一項中立的科學技術,在任何領域的套用都會有其利弊,說說不希望發生的事或許更恰當。AI倫理問題帶來的危險有:

1. 演算法歧視

演算法是一種數學表達,非常客觀,但怎麽會產生歧視呢?

曾經亞馬遜使用了A.I.驅動演算法,利用歷史數據篩選優秀的職位候選人時,成為了著名的一個僱用偏見事件。因為之前的候選人選拔就存在性別偏見,所以演算法也傾向於選擇男性。

而一些影像辨識軟件會將黑人錯誤地標記為「黑猩猩」或者「猿猴」。前微軟副總裁沈向洋曾還談到人工智能的「偏見」——你在網絡搜尋「CEO」會發現,出來的結果基本上沒有女性,亞洲人面孔很少。

隨著演算法決策越來越多,類似的歧視也會越來越多。而且,演算法歧視會帶來危害。一方面,如果將演算法套用在犯罪評估、信用貸款、僱用評估等關切人身利益的場合,一旦產生歧視,必然危害個人權益。另一方面,深度學習是一個典型的「黑箱」演算法,連設計者可能都不知道演算法如何決策,要在系統中發現有沒有存在歧視和歧視根源,在技術上是比較困難的。

2. 私密憂慮

很多AI系統,包括深度學習,都是大數據學習,需要大量的數據來訓練學習演算法。數據已經成了AI時代的「新石油」。但也同時帶來新的私密憂慮。

之前美國聯邦貿易委員會向Facebook開出50億美元的巨額罰單,據稱是與一年前Facebook一次大規模的數據泄密事件有關。

又比如人臉辨識,是人工智能最具爭議的套用之一。美國人臉辨識創業公司Clearview AI曾稱其所有客戶名單被盜,黑客竊取的封包括其整個客戶列表、客戶進行的搜尋次數以及每個客戶開設的賬戶數量等資訊。其醜聞的余波表明,人臉辨識技術引發了人們對安全和人權的重大擔憂。

一方面,如果在深度學習過程中使用大量的敏感數據,這些數據可能會在後續被披露出去,對個人的私密會產生影響。另一方面,考慮到各種服務之間大量交易數據,數據流動不斷頻繁,數據成為新的流通物,可能削弱個人對其個人數據的控制和管理。

3. AI的安全風險

AI安全始終是人們關註的一個重點,美國、英國、歐盟等都在著力推進對自動駕駛汽車、智能機器人的安全監管。此外,安全往往與責任相伴。如果自動駕駛汽車、智能機器人造成人身、財產損害,誰來承擔責任?如果按照現有的法律責任規則,因為系統是自主性很強的,它的開發者是難以預測的,包括黑箱的存在,很難解釋事故的原因,未來可能會產生責任鴻溝。

4. 機器人權利

即如何界定AI的人道主義待遇。隨著自主智能機器人越來越強大,那麽它們在人類社會到底應該扮演什麽樣的角色呢?自主智能機器人到底在法律上是什麽?自然人?法人?動物?物?我們可以虐待、折磨或者殺當機器人嗎?歐盟已經在考慮要不要賦予智能機器人「電子人」的法律人格,具有權利義務並對其行為負責。

觀點更為中立的科學家提出要為人工智能「立法」。以德國交通運輸與數碼基礎建設部下屬的道德委員會公布的一套被稱為世界上首部的自動駕駛道德準則為例,這是目前全球範圍內唯一一個被列為行政條款的與AI相關規範,但在具體實施過程中依然存在大量技術難題,比如如何讓無人駕駛的AI系統能準確了解條款中的含義。

準則中明確,人類生命一定是首要任務,在事故無可避免的情況下,人的生命要比其他動物、建物都還重要。另外,當碰到「直走會撞死1個老人,但救2個小孩;急轉彎會撞死2個小孩,但救一個老人」這種著名的道德難題時,規範中指出,自駕系統不得以任何年齡、性別、種族、是否殘疾等條件,作為「犧牲」和「獲救」的判斷選擇標準。因為人類的生命都是平等的 [3] 。事實上,這一人類的生命都是平等的判斷,會加劇自動駕駛系統的選擇難度。

同時,這部規則意味著它可能事實上無法解決自動駕駛的道德悖論,還會導到更多沖突的發生。

所以說,這一原則並沒有解決問題(攤手)。

去年的4月9日,歐盟釋出了AI倫理指導方針,公司和政府機構未來開發AI時應遵循7大原則。以下是歐盟AI倫理指南摘要:

人的管理和監督: 人工智能系統應受人的基本管理和支持人的基本權利,從而使公平社會得以實作,而不是減少、限制或誤導人類自治。穩健性和安全性: 值得信賴的人工智能要求演算法足夠安全、可靠和穩健性,能夠處理人工智能系統在各個周期階段的錯誤或不一致。

私密和數據管理: 公民應該對自己的數據有完全的控制權,而與之相關的數據不會被用來傷害他們。

透明度: 應確保人工智能系統的可追溯性。

多樣性、非歧視性和公平性: 人工智能系統應考慮人類的各種能力、技能和需求,並確保其系統的可存取性。

社會和環境福祉: 應采用人工智能系統來促進積極的社會變革,增強可持續性和生態責任。

問責制: 應建立機制,確保對人工智能系統及其成果負責和問責 [4] 。

參考

- ^ 如何與AI談倫理?IT時報 https://baijiahao.baidu.com/s?id=1600879878125466392&wfr=spider&for=pc

- ^ a b 藍江,人工智能的倫理挑戰,光明日報(2019年04月01日) http://theory.people.com.cn/gb/n1/2019/0401/c40531-31005609.html

- ^ 新浪科技,無人駕駛道德準則出爐 但它可能加劇無人駕駛的混亂(2017年9月) https://tech.sina.com.cn/it/2017-09-01/doc-ifykpysa2451903.shtml

- ^ 騰訊科技,歐盟釋出AI倫理指導方針 未來開發AI「以人為本」是關鍵(2019年4月9日) https://tech.qq.com/a/20190409/000488.htm