我們都知道,【我的世界】(MC)是一款 沙盒開放世界遊戲 ,玩家可以根據自己的想象,建造出完全屬於自己的世界。它著重於讓玩家探索,並可以與環境物品進行互動,使得玩家在遊戲中有極大的自由度和開放度。

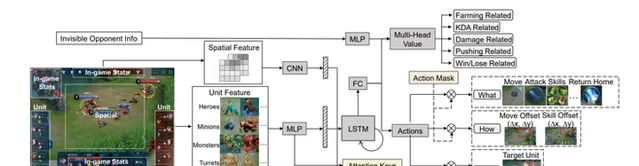

在以往的例子中,AI能在MOBA類遊戲和即時戰略遊戲中超越專業選手,例如騰訊在王者榮耀訓練出來的「 絕悟AI 」:

DeepMind在星際爭霸中訓練出來的「 AlphaStar 」:

1.VPT模型

一般來說,遊戲的自由度越高,讓AI學習人類知識並自由探索越難。因此OpenAI利用【我的世界】的玩家視訊來學習,訓練出超大的預訓練模型VPT。對於熟練的人來說,在MC中制作鉆石鎬,需要超過20分鐘(包含24000個動作),這對人來說可能比較簡單,但是對於AI來說,需要較為復雜的模型。這個模型用了 按鍵和滑鼠移動 的人機介面,使其更加通用,代表著使用通用智慧體的電腦往前邁向了一步。

那讓我們先來看一下訓練出來的智慧體效果。

它能夠完成一般的基礎動作,例如

除此之外,它也能夠完成復雜的動作:

2.論文細節

2.1預訓練階段

在互聯網上存在大量公開的視訊,人類可以從中進行學習。比如你可以學習演講,學習畫畫,學習如何在MC中建造復雜的房子。但是對於遊戲來說,僅僅記錄了所發生的事情,但是不知道真實玩家中 不知道滑鼠移動和按鍵的確切順序 ,也就是說需要模型學習玩家的操作序列。打個比方,類似於在NLP中訓練BERT模型,模型可以學習每個單詞的上下文序列等。

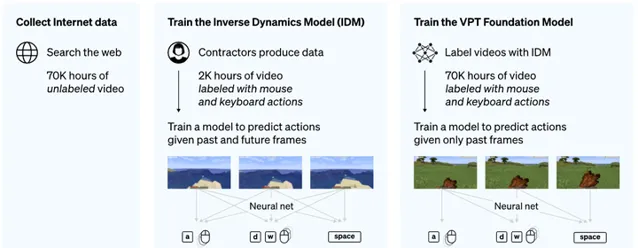

論文中主要用到半監督的方法去實作VPT模型:

收集小型的數據集,包含遊戲視訊和玩家的動作序列(滑鼠和按鍵序列);利用這些數訓練逆動力學模型IDM,使用過去和未來的動作特征,來預測每一步操作。

IDM模型訓練比較簡單,因此需要的數據量不會很多。利用訓練得到的IDM模型, 去標記大量的線上視訊數據集。

該研究選擇在【我的世界】中驗證,這是因為:

VPT模型在70000小時的視訊上進行訓練,相比於強化學習從頭開始訓練,它學會砍樹木以收集原木,將這些原木制作成木板,然後將這些木板制作成一個工作台;這個序列需要一個精通的人大約50秒或1000個連續的動作。

2.2下遊微調

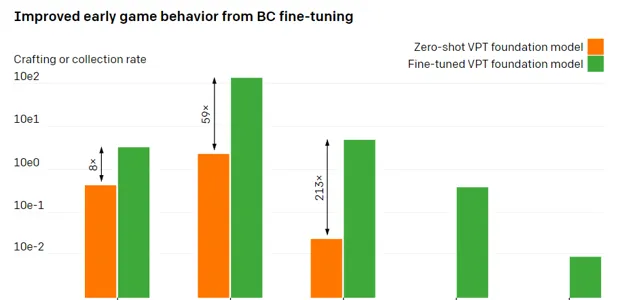

預訓練階段,模型能夠學到一些比較寬泛的動作。為了讓模型學習更多的知識,並且讓它專註於精細化的任務,通常需要對預訓練模型進行微調。OpenAI讓人類玩家在【我的世界】中遊玩10分鐘,並用基本的材料建造房子,希望增強基礎模型可以學習到「早期遊戲」技能的能力。對這種數據集進行微調後,模型學會了更深的技能: 制作木頭和石器工具。

2.3數據擴充套件

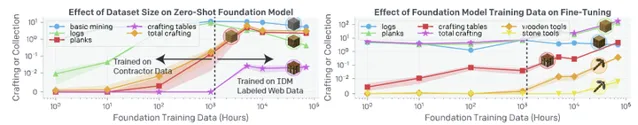

研究中有一個重要假設:在使用同一份人類標記的視訊數據下,訓練IDM模型(VPT中的第一步方法),要比直接訓練人類行為複制BC模型要有效得多。為了驗證這個假設,研究者把數據規模從1小時擴充套件到7w小時。

下圖中,縱座標為不同技能的完成水平,比如挖掘、制作等。虛線部份左邊為沒有使用IDM模型,右邊為使用了IDM模型。

圖中可以看到,盡管增長了數據量,在沒有IDM模型上,制作能力有所上漲,但一直沒有石器工具的出現。直到使用IDM模型,才出現石器工具。

2.4下遊微調+強化學習

當給定一個指定的獎勵函式,使用強化學習能夠激發模型達到較高的水平並超越人類的能力。但是大多數的強化學習任務利用隨機初始化進行訓練。而本模型VPT可以稱為強化學習的初始化模型,因為模擬人類行為可能比采取隨機行動更有幫助。

下圖展示了模型在制作 鉆石鎬 的過程:

從結果發現,使用隨機初始化進行RL訓練幾乎沒有獲得任務的reward。

相反,使用VPT模型進行微調不僅可以學習制作鉆石鎬(在10分鐘的Minecraft劇集中,它會制作2.5%),而且在收集鉆石鎬之前的所有物品方面,它甚至具有人類水平的成功率。

目前該計畫已經開源,具體計畫程式碼地址如下:

有興趣的小夥伴可以看一下具體論文。

本期就到這裏拉,我是leo,我們下期再見~