据了解,在大模型领域有研究人员认为智能与数据压缩紧密相关甚至是等价的。这种观点在大模型的快速发展中变得更加引人注目。

基于此,一些研究者提出大模型的压缩理论,将语言建模(Language Modeling)和压缩建立等价关系,从全新角度阐述了大模型训练的本质以及模型智能的来源。

但是,对于关于压缩能力和智能之间关系的实验证据却很十分有限。

为此,香港科技大学团队希望填补这一空白,通过实验研究来探讨大模型之中压缩和智能的关系。

其希望借此回答这样一个问题:如果一个大模型相比另一个大模型,能够以无损的方式使用更少的比特编码一个文本语料库,这是否表示它具有更高的智能?

在本项工作中,该课题组遵循「智能与数据压缩紧密相关甚至是等价的」的定义,从大模型在下游任务中的能力来衡量它的智能水平。

并聚焦于三个具有代表性的能力:知识能力、编程能力和数学推理能力。

为了实现上述的目标,他们在多达 30 个大模型和 12 项基准(benchmark)上进行实验,针对不同的大模型进行横向比较。

这些大模型有着不同的架构设计、不同的分词器、以及在不同的数据上训练。

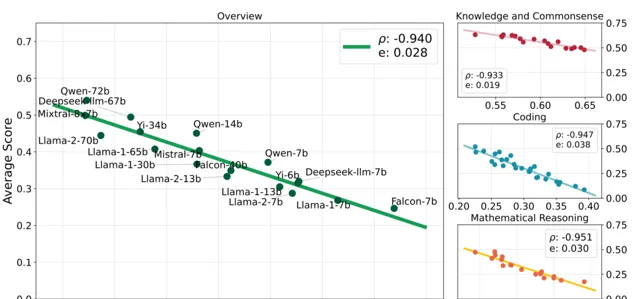

结果如下图所示:

总体来看,大模型的下游能力(Y 轴)和其压缩能力(X 轴)高度线性相关,二者的皮尔森相关系数为-0.94。

并且,这种线性关系可以很好地延伸到各个子领域(图片右侧),甚至延伸到大多数的基准测试。

在实验设计上,他们收集和清洗各自领域的最新语料数据,并在收集的语料上测试大模型的压缩性能。

具体来说,针对知识能力、编程能力和数学推理能力,该团队分别从 Common Crawl、GitHub 和 arXiv 收集语料,并采用 标准的清洗流程针对数据进行清洗。

与此同时,他们使用 bits per character 作为模型压缩能力的衡量指标,并引入了「上下文窗口统一」和「滑动窗口」等方法使得评估结果更准确、以及更具有可比性。

最后,该团队在一系列下游任务上评估这些大模型,使用平均基准分数来衡量其特定领域的智能,并评估智能和压缩两者的线性相关关系。

总的来说,课题组揭示了这样一个规律:即大模型的智能(下游任务能力),几乎与它们压缩外部语料的能力呈线性相关。

凭借此,本次研究为大模型的智能水平评估提供了全新的角度,为使用压缩能力作为模型评测指标提供了依据。

据介绍,使用压缩能力作为评估指标具有无监督、灵活和可靠的特点。

同时,由于不需要数据标注,测试所需的数据可以很方便地进行迭代,从而可以减轻大多数评估方法所面临的数据污染和过度拟合问题。

由此可见,本次成果在大模型的评估和优化方面具有很大的潜在价值。

日前,相关论文以【压缩线性代表智能】 (Compression Represents Intelligence Linearly)为题发在 arXiv 。

图 | 相关论文(来源:arXiv)

香港科技大学博士生黄裕振、张静涵是(共同)第一作者,指导老师为何俊贤。

图 | 黄裕振(来源:黄裕振)

另据悉,他们已经在 GitHub 开源了所使用的语料数据集和数据收集代码等(https://github.com/hkust-nlp/llm-compression-intelligence)。

本次课题之中,尽管该团队尽可能全面地开展研究,但其依然存在一些局限性,但也为实现新的突破带来了一定机会。

机会之一在于:大模型通常可以分为两种基础模型(Base model)和微调模型(Finetune model)。本项研究只关注了基础模型,而微调模型的测试和评估依然有待探索。

机会之二在于:本次研究中的实验主要针对短文本和中长文本,对于长文本的场景依然有待探索。

机会之三在于:本次结论可能并不适用于未得到充分训练的模型,因此可以探讨在这些模型中压缩效率与智能之间的关系。

参考资料:

1.https://arxiv.org/pdf/2404.09937

运营/排版:何晨龙

01/ 科学家研发数字非福斯特电路,功率处理能力提高3个数量级,能用于远距离声通讯或无线通信

02/ 清华团队远赴云南养蚊子,借此发现新型抗病毒细菌,为蚊媒传染病防控提供有力方案

03/ 马普所团队补齐固-液界面的基础理论缺失,突破纳米涂层的传统认知,推动无氟纳米涂层的应用

04/ 科学家阐释纯量子AI算法理论,对同类算法具有普遍指导意义,或极大提升生化及图文领域模型性能

05/ 让心衰治疗告别「治标不治本」:科学家发现新型小分子激动剂,能有效缓解心肌肥大和纤维化