沒有具體方向的話建議先看一些機器人視覺公司的方案,比如pickit! 梅卡曼得,我就不一一舉例了,百度一個進入看整體方案描述就可以的。

假設你是要做三維bin picking類的分揀系統:

1影像處理,非常重要,這個不用說了吧,起碼對著經典的課程擼一遍,或者跟著賓夕法尼亞的機器人感知學,再或者去睿慕課找一門課程上1.5或者2倍速聽一聽。

2手眼標定是會用到的,雖然不用定位為研究方向,解個ax=xb還是機器人視覺解決中比較重要的一環。

3機器人路徑規劃,這個可做可不做,用一些機器人內建的外部介面,比如urscript上movel movej servoj,再比如ABB的EGM,KUKA的…… 在你去百度機器人視覺公司的時候會發現他們支持的機器人類別都是差不多的,因為都是呼叫的外部介面。如果想考慮避障和效率問題等,比如要規劃抓取箱體內的物體或者機械臂需要盡量避開正上當的相機的視野,就需要做路徑規劃的工作,這部份知乎上大牛的文章和推薦都比較多。

4很有可能上面的內容都不想了解,只想做深度圖處理現在,深度圖顧名思義就是帶有深度資訊的圖,這是一句廢話,但是不說好像還不行。我們平時帥氣的自拍是有顏色的,每個裏麪包含了RGB資訊,那黑乎乎的深度圖裏就是DEPTH啦,當然也可以RGBD。以下稱Depth為z值吧,有了z值透過相機內參就可以得到xy值,也就是深度資訊了。如果說不明白內參的話,建議去學第一條!

6物料該怎麽抓取,這是一個要麽深要麽淺的問題,可以做學術研究,也可以直接離線或線上示教,看自身需求,大多數在展會上看到的方案都是後者。

7怎麽匹配到你要抓取的物體,也就是抓取系統中最最重要的一環,如何匹配定位到待抓取物體,這個是可以作為研究方向的主攻的,可以先去了解opencv pcl二維或者三維的模版匹配,再去做基於深度學習的物體檢測。這個地方展開說的話內容就太多了,手機碼字不易也沒有什麽圖,幹巴巴的,等我有時間用電腦再補充,假如有人看的話……

基於深度學習的物體抓取目前我接觸到的主要有兩條路,基於彩色圖分割+傳統icp類:這種方法的好處是對於分割,我們本身的訴求就是找到待抓取物體的類別及在影像中的位置,大大提高匹配定位的效率,而分割後對映到深度圖上的三維資訊經過傳統方法定位得到的pose更準,甚至如果分割模型做的準一點,對於小食品及快遞包裹類,後面只需要定義一個吸取規則就可以了;另外就是直接上三維深度學習出6d pose了,這部份我接觸過很多種了,從dexnet GPD 到 poseCNN ssd6d等,還有一些其他小天才們嘗試過的方法我就先不提了,好處是更適合做研究發paper,但是做出來的東西沒有前面的路線高效高成功率。

上幾個圖:

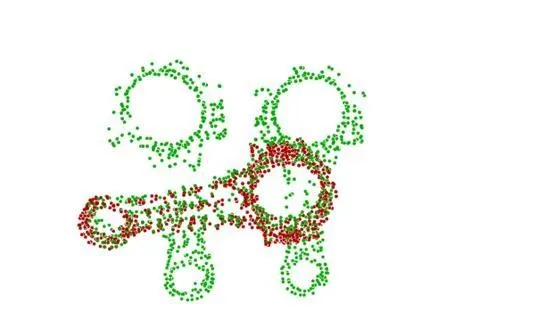

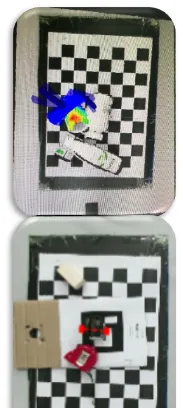

匹配的效果大概是這個樣子:

其他:

硬件的話,買一個深度相機realsense這種才一千多,學習還是夠用的。

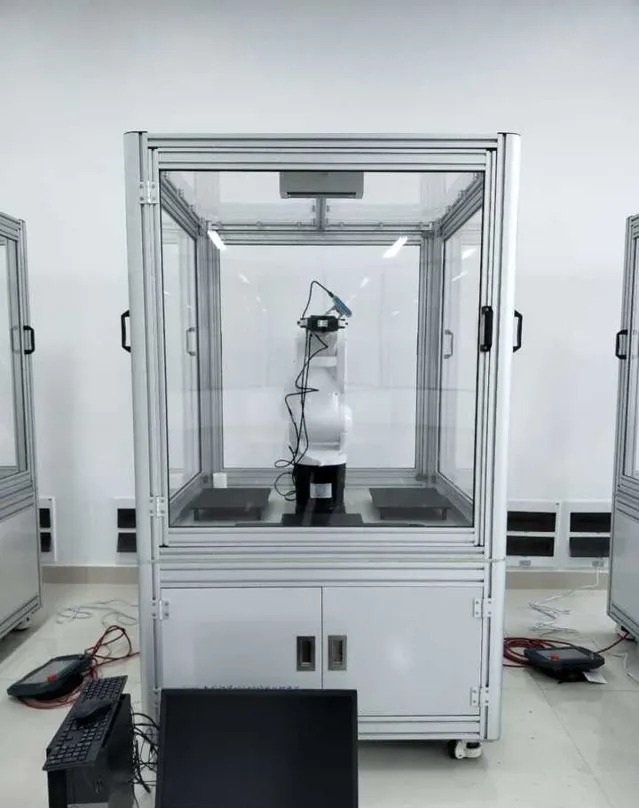

上一個我的實驗環境:

先說這麽多……手機碼字很痛苦,主要我要點外賣了。