近日,有位對技術一竅不通的朋友說想買特斯拉,因為它配備了 「你站著不動,讓車來找你」 的自動駕駛功能。

我大吃一驚,這讓人感覺到:自動駕駛雖然暫時還只是從業者關註的話題,但 也許用不了幾年,就會成為影響普通群眾購車決策的關鍵因素 。

既然如此,作為普通人也有必要提前了解一下自動駕駛的關鍵技術,但沒必要像從業者那樣了解得那麽細致。本回答就 面向普通群眾作一個通俗易懂的介紹 。

自動駕駛需要什麽技術?

自動駕駛需要什麽技術?要回答這一問題,其實沒必要翻開書本,只需要回想一下平時咱們是怎麽開車的:

什麽是自動駕駛?

——就是 全部或部份替代 這些本來由人來執行的功能。

自動駕駛需要哪些技術?

——自然而然地,需要 環境感知 、 行為決策(廣義) 與 車輛控制 技術。

那麽,哪項技術在當下的技術門檻最高、最關鍵呢?

首先,我們可以將 車輛控制技術 排除在外。這並不是說車輛控制技術簡單,L1級自動駕駛只能幫駕駛員自動加減速或自動轉向,進步到L2級的「同時實作加減速和轉向」,也是花了汽車行業好長時間。

但是,它總體上是一個機電控制的工程問題,相關技術與供應鏈基本成熟;雖然高階自動駕駛出於安全性考慮,未來還會有制動和轉向的冗余備份要求,總歸是逃不出工程領域,而工程問題終究是能解決的。

其次,至於行為決策(廣義),像路徑規則這種功能,導航軟件已經做得比人還好了;在環境感知做到絕對正確的情況下,什麽時候加速、什麽時候剎車、什麽時候轉向的決策,也並不難(可能還涉及到一些法律與倫理問題,不屬於技術領域)。

如此一來,剩下的就是環境感知了。 環境感知對於汽車行業是一個新的挑戰,也是實作自動駕駛最關鍵的一步,是最重要的環節 。

環境感知的兩種技術路線

正是因為環境感知太難實作,才引發了技術路線上的差異。最有意思的標誌性事件,是特斯拉的創始人馬斯克在釋出自家Autopilot 3.0的時候,扔出一句頗具爭議的話,炮轟了大半個自動駕駛行業:

「 激光雷達太蠢了,誰依靠激光雷達誰就會完蛋。(Lidar is a fool. Anyone relying on lidar is doomed)」。

激光雷達(Lidar)是什麽?馬斯克為什麽這麽說?

要回答這一問題,就要提到自動駕駛環境感知的兩大技術路線: 弱感知+超強智能 vs 強感知+強智能 。

一、弱感知+超強智能

馬斯克在發言中堅持的 弱感知+超強智能 技術路線,是指 主要依賴網絡攝影機與深度學習技術 實作環境感知,而 不依賴於激光雷達 。

這種技術路線有點仿生學的味道:既然人可以靠一雙眼睛就可以開車,那麽車也可以靠網絡攝影機來看清周圍環境。對於把第一性原理當成顛覆式創新秘訣的馬斯克來說,堅信這種技術路線可以說是意料之中。

我也很喜歡這種具備自然美感的技術路線,但問題在於: 超強智能何時才能實作?

要知道, 技術路線之爭要講究商業化的節奏與速度 。一百年前,內燃機沒有電機的電磁學簡潔美感,但內燃機汽車還是打敗了電動汽車;十幾年前,等離子電視並非一無是處,但還是敗給了液晶電視。

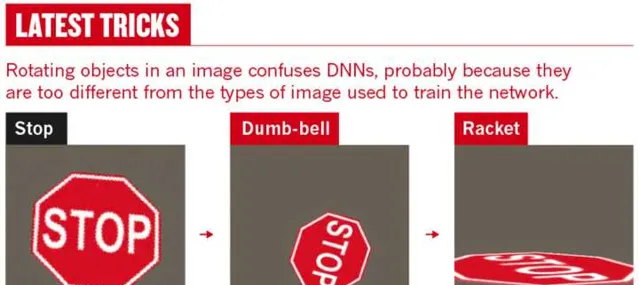

現實問題是,深度學習現在還停留在尷尬的「辨識」階段。就比如,發表在Nature上的「Why deep-learning AIs are so easy to fool」一文 [2] 舉了一個例子: 特征非常明顯的一個「STOP「標誌,變換角度之後就被AI辨識成了啞鈴(Dumb-bell)與球拍(Racket)。

這就很僵硬了。這樣的辨識結果,怕是還不如隔壁村的二傻子吧?

所謂的「弱「感知與「超強「智能都是相對的。我們覺得人類眼睛的視覺很強了,是因為就 連再愚鈍的人類也配備了超強智能的辨識能力 ,只是大家習以為常、沒有留意而已。

上述情況還是在光線良好的情況下,如果是夜晚、大霧、雨雪的條件下,辨識效果還會再打折扣。發生在美國的特斯拉撞大貨車的那次「事故」,就是因為網絡攝影機在強反光的情況下把白色的大貨車辨識成了天空。

辨識能力尚且如此,那後續的行為預測與邏輯推理就更是無源之水了 。因此,當前水平的深度學習,離人類的「超強智能「還是有差距的;至於什麽時候能達到甚至超過人類的水平,不知道。

在深度學習技術的進步速度存在諸多未知的情況下,自動駕駛行業總不能停下來等待吧?於是,另外一個思路出現了: 如果超強智能暫時難以達到,那我們給車賦予超過人類眼睛的感知能力啊,是不是也行呢? 這就是強感知+強智能的技術路線。

二、強感知+強智能

與弱感知+超強智能的技術路線相比,強感知+強智能技術路線的最大特征,就是增加了激光雷達這個傳感器,從而大幅提高感知能力。

在介紹激光雷達的原理之前,我們先通俗地打個比方:這可以說是一種 暴力解決方案 ,用千裏眼把所有角落都掃一遍,理論上周圍有啥都能知道;再加上稍微一點學習演算法,就可以勾勒出障礙物的範圍,知道車往哪裏開了。

就像葫蘆娃中的二娃,他不像鐵娃、火娃一樣擁有暴力技能,作為心地單純、缺乏計謀 (非超強智能) 的毛孩子,通常來說碰到妖怪只能束手就擒。但事實上,憑借著千裏眼的特異功能 (強感知) ,他也打了不少勝仗。

這種方法聽起來有點太耿直,但在目前深度學習遇到瓶頸的情況下,這種技術路線通往高階自動駕駛可行性更高一些。

事實上,這個技術路線上的玩家並不少,像 谷歌Waymo、百度Apollo、Uber、福特汽車、通用汽車等人工智能企業、出行企業、傳統車企都處在強感知+強智能的技術陣營中 。

此外,暴力的方案往往也有一種美,比如老毛子的喀秋莎火箭炮,雖然沒啥精妙的制導方法,也不需要知道敵人的精確位置,一打起來就把足量的火力送過去,保證覆蓋度就行。

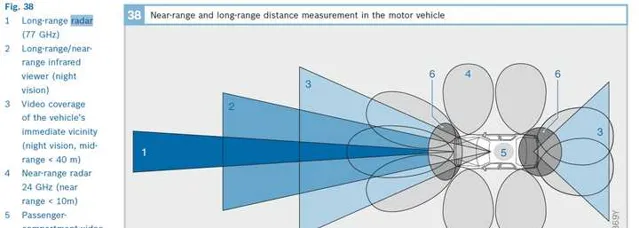

下圖來源 [3]

對於習慣追求暴力美學的老毛子來說,這種方法 最保險 。對於人命關天的自動駕駛來說, 多一些追求保險的觀念, 也不是什麽壞事。

環境感知的關鍵傳感器

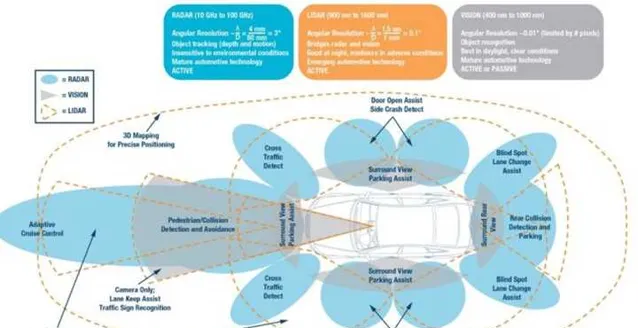

無論何種技術路線,環境感知的核心都在於「傳感器」(Sensor)這一古老的名詞。咱們前面提到的 網絡攝影機 與 激光雷達 ,都是傳感器。

除了這倆之外,與自動駕駛關系密切的傳感器還包括另外兩種雷達: 超聲波雷達 (Ultrasound Radar)與 毫米波雷達 (Radar)。

突然多了好幾個專業名詞,是不是頭都要大了? 一開始我也有這種感覺,後來自己總結出一個簡便的記憶方式,給大家分享一下:

關於 激光雷達的原理 ,可以理解為數碼量: 一條激光過去是直的,相當於數碼掃點,理論上把所有周圍的點掃一遍,就能清楚知道周圍環境是什麽樣 。

其實,對車輛造型掃描(逆向)也就是這個原理。當然,實際的工程套用中,還是有不少細節問題。前文提到激光雷達的分辨率很高,那就意味著每次只能掃了很小一塊區域,這就意味著要解決兩個問題:

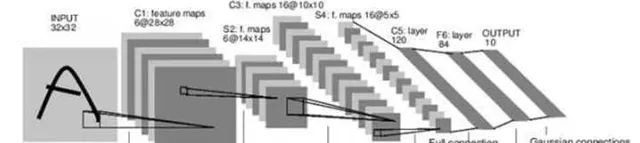

與激光雷達不同, 網絡攝影機的采集的是像素資訊 ,就和人眼看到的差不多。與人不同的是,人眼配備了超強的(人工)智能處理器,在毫不費力的情況下辨識出環境中的車道、車輛、行人等等,而對車輛來說,像素資訊只是無意義的海量數碼,必須經過如下的抽象、重構等復雜過程,必須依賴 超強智能 才能達到人類的辨識效果。

下圖來源於一本非常基礎的深度學習教材,我們可以看到:即便是一個簡單的字元,想準確辨識都需要復雜的處理過程。

最後才提到毫米波雷達,似乎暗示著毫米波雷達不重要? 恰恰相反,毫米波雷達非常重要 :

正因為大家都需要毫米波雷達,爭議比較少,才不經常拿出來被比較與提及,但這並不意味著它不重要。

本題的提問者 @亞德諾半導體 將上述環境感知傳感器放在一起,從各個維度進行了一個全面的比較,比較專業、資訊量很大,有興趣的同學可以仔細看一下。

網絡攝影機與雷達解決了「我周圍都有啥「的問題,車輛還需要解決另外一個問題: 我在哪,我有多快 ?

對於日常定位與測速需求來說,單獨使用GPS足矣;但對於自動駕駛來說,僅使用GPS在精度、響應速度與場景覆蓋率(隧道、車庫)都不夠,還需要一種加速度傳感器,也就是 IMU慣性測量單元 ,並透過卡爾曼濾波等方法將二者資訊融合,形成最優估計。

吃瓜群眾可能有個疑問,明明是測 加速度 的,為啥叫 慣性 單元呢?我們回想一下牛頓第二定律,就不言自明了: 加速度 = 作用力/慣性(質素)

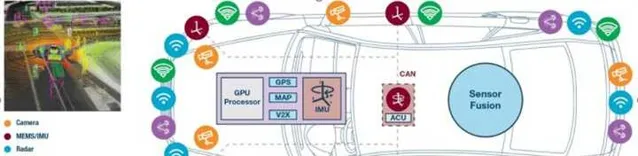

好了,做一個小結,自動駕駛的環境感知需要完成以下工作:

大家都知道,自動駕駛是汽車行業的一項革命性技術,蘊含著巨大的商業價值。如果要投身到這個市場,那麽問題來了 :應該投入到哪項傳感器技術呢?

半導體行業領導者ADI @亞德諾半導體 的回答是: 小公司才做選擇,大公司我全都做!

更詳細的介紹,請移步官方機構號的這篇文章:

參考

- ^ 人的眼睛相當於什麽參數的鏡頭? https://www.zhihu.com/question/26507130/answer/33024802

- ^https://www.nature.com/articles/d41586-019-03013-5

- ^https://www.zhihu.com/question/67311158/answer/251624746

- ^ Robert Bosch GmbH Ed. Bosch Automotive Electrics and Automotive Electrionics, System and Components, Networking and Hybrid Drive, 5th Edition. Springer Vieweg

- ^https://zhuanlan.zhihu.com/p/25131152

- ^https://www.zhihu.com/question/65799732/answer/861361221